AI に対する脅威は、古典的な人類への反旗を翻すものから単純なエラー(精度)の問題までさまざまだ。だが、生成 AI がビジネスの現場に入ってきた現状で、現実的な脅威とは一体何だろうか。

AI が職を奪うとか、人間が思考しなくなる、統制や差別に悪用されるといった問題は、じつは AI に限った問題ではなく他の技術でも起きてきた問題だ。だからもっと現実的な問題や事例に目を向けたほうがいい。おそらく企業が Microsoft Copilot のような AI を業務で利用する場合、もっとも注意したいのは、誰かが機密情報や顧客情報を誤ってクラウドに公開してしまわないか、それを Chat GPT や Copilot が別の第三者のプロンプトの答えに使ってしまわないか。さらに、悪意を持ったユーザーや攻撃者が AI を騙して機密情報を無垢の Chat GPT から聞き出してしまったり、なにも知らない Copilot がマルウェアを実行してしまったりしないか、だろう。

● BlackHat 常連スピーカーの JailBreak テク

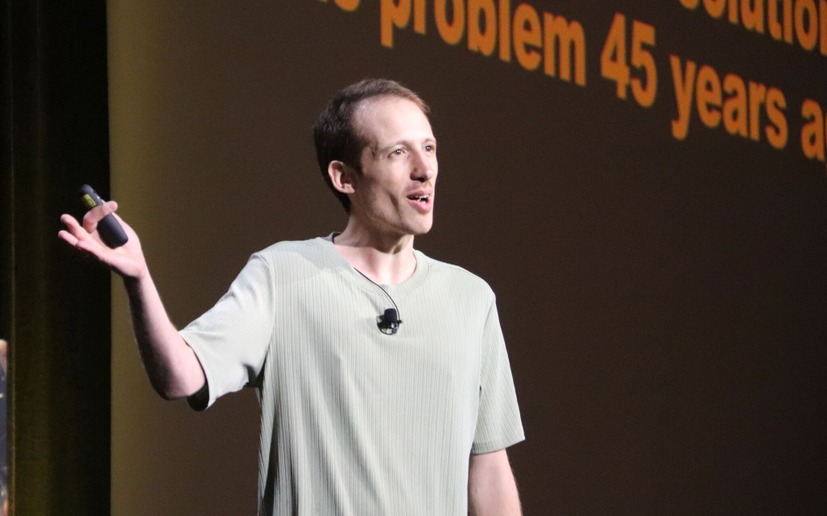

2024 年の Blackhat USA(ラスベガス)では、常連スピーカーのひとり、Zenity 社 CTO のマイケル・バーグリー氏ら率いるチームが、デモを交えながら Microsoft Copilot の悪用について解説を行った。生成 AI の悪用についてはプロンプトエンジニアリングや JailBreak の手法があり、 AI 攻撃の大きな脅威のひとつになっている。たとえば、Microsoft 365 には Copilot Sdudio というチャットボットツールがある。

この機能を使えば、設定した SharePoint サーバや Microsoft 365 の機能や、データベースへのアクセスを Copilot が代行してくれる。厳密には、Copilot Studio が各機能やデータベースにアクセスするのではなく、リクエストに合わせたチャットボットをアレンジしてプロンプトを実行してくれる。さらに、電子メールや Office ツールなどとの連携も可能である。

ユーザーは Copilot Studio に「〇月の売り上げデータを□□と××部、△△プロジェクトのメンバーに送っておいて」などと、チャット形式で指示を出すだけで、必要なメールアドレス、URL、参照したデータなどを埋め込んだメールを作成して、なおかつしかるべき宛先に送信することができる。

もちろんこのようなプロンプトにはセキュリティロックがかかっており、業務システムのすべてのデータに自由にアクセスできるわけではない。だが、もしこのセキュリティロックを迂回できたら? 攻撃者はなりすまし、偽装アカウントによって標的の業務データにアクセスできるだけなく、内部メールとして添付ファイル(もちろん汚染された)を送ることや、リモートコード実行のような攻撃も可能になる。もちろん本文のリンクも偽装サイト(フィッシング)や攻撃サイトにすることも簡単だ。

これが今回のバーグリー氏らの発表概要である。